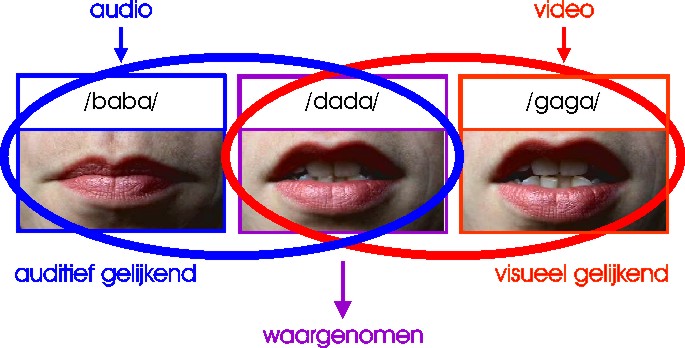

Figuur

1: Het McGurk-effect. Een auditieve stimulus /baba/, gecombineerd met een visuele

stimulus /gaga/ zal worden waargenomen als /dada/, omdat /baba/ en /dada/

auditief op elkaar lijken en /gaga/ en /dada/ visueel op elkaar lijken.

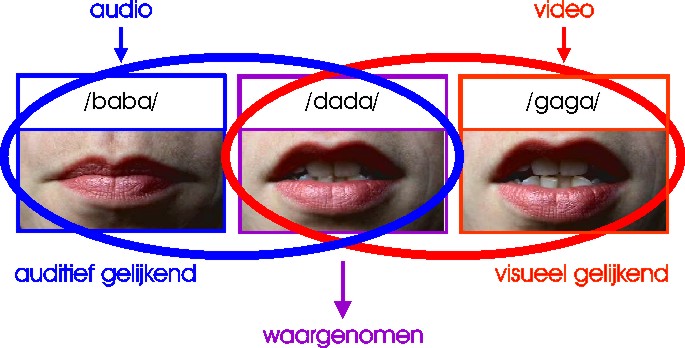

Figuur

1: Het McGurk-effect. Een auditieve stimulus /baba/, gecombineerd met een visuele

stimulus /gaga/ zal worden waargenomen als /dada/, omdat /baba/ en /dada/

auditief op elkaar lijken en /gaga/ en /dada/ visueel op elkaar lijken.

Audiovisuele integratie bij spraakverstaan (projecten 2004)

Het combineren van informatie uit verschillende sensorische bronnen (visueel, auditief, tactiel etc.) speelt in het dagelijks leven een belangrijke rol. Bij nagenoeg alles wat wij in onze omgeving waarnemen wordt informatie vanuit verschillende zintuigen gecombineerd. Bij mens en dier lijkt dit proces probleemloos te verlopen. Toch is het bijzonder complex en de mechanismen die ten grondslag liggen aan de integratie van informatie vanuit verschillende zintuigen is nog grotendeels onbekend.

Het doel van dit project is om m.b.v. psychofysische technieken meer te weten te komen over de integratie van auditieve en visuele informatie bij de verwerking van spraakstimuli. Voor spraakverstaan is zowel auditieve als visuele informatie van belang. Met name wanneer de signaal-ruis verhouding van het auditieve signaal verslechterd kan het zien van de spreker de verstaanbaarheid van spraak sterk verbeteren. Je zou kunnen denken dat voor spraakverstaan auditieve informatie belangrijker is dan visuele informatie en dat deze laatste component enkel invloed uitoefent wanneer het auditieve signaal niet duidelijk genoeg is. Dit blijkt niet waar te zijn: ook wanneer de auditieve stimulus een hoge signaal ruis verhouding heeft en in principe probleemloos verstaan kan worden zonder visuele informatie, blijkt de visuele informatie te worden gecombineerd met auditieve informatie. Het z.g. McGurk-effect laat dit duidelijk zien. Dit effect werd ontdekt door McGurk en McDonald (McGurk and MacDonald, 1976). Zij boden proefpersonen tegelijkertijd auditieve stimuli (bijvoorbeeld de klankenreeks /baba/) en visuele stimuli (het beeld van een gezicht dat bijvoorbeeld /gaga/ zei) aan. De verrassende uitkomst van dit experiment was dat veel proefpersonen in bovenstaand geval /dada/ hoorden (!). Zoals in figuur 1 is uitgebeeld, heeft een proefpersoon bij het horen van /dada/ auditieve en visuele informatie ge´ntegreerd.

Figuur

1: Het McGurk-effect. Een auditieve stimulus /baba/, gecombineerd met een visuele

stimulus /gaga/ zal worden waargenomen als /dada/, omdat /baba/ en /dada/

auditief op elkaar lijken en /gaga/ en /dada/ visueel op elkaar lijken.

Figuur

1: Het McGurk-effect. Een auditieve stimulus /baba/, gecombineerd met een visuele

stimulus /gaga/ zal worden waargenomen als /dada/, omdat /baba/ en /dada/

auditief op elkaar lijken en /gaga/ en /dada/ visueel op elkaar lijken.

De mate waarin visuele en auditieve informatie wordt ge´ntegreerd hangt o.a. af van de synchroniciteit van de auditieve en visuele stimulus. In een vorig project is uitgezocht hoe groot het tijdsvenster is waarin auditieve en visuele informatie wordt gecombineerd. De resultaten zijn in een aantal opzichten opmerkelijk en doen nieuwe vragen rijzen waarnaar jullie in een project onderzoek kunnen verrichten. De opmerkelijke resultaten zijn de volgende:

Het McGurk-effect bij verschillende signaal-ruis verhoudingen.

Het eerste gegeven roept de vraag op of het niet tot nul dalen van de McGurk-respons wordt veroorzaakt doordat de signaal-ruis verhouding van de auditieve stimulus niet hoog genoeg is geweest. Dit kan worden nagegaan door het McGurk-effect bij verschillende auditieve signaal-ruis verhoudingen te bestuderen. Dit is ook interessant omdat in de literatuur waarin onderzoek naar het McGurk-effect wordt besproken vaak geen melding wordt gemaakt van de gebruikte signaal-ruis verhouding van het auditieve signaal. Toch is te verwachten dat deze signaal-ruis verhouding de waarneembaarheid van het McGurk-effect be´nvloedt.

Kan de mate van asynchroniteit waarbij de audiovisuele integratie maximaal is worden be´nvloed?

Het tweede gegeven - de integratie is maximaal bij een delay van de auditieve stimulus van ca. 100 ms - wordt in de literatuur vaker beschreven. Zo blijkt uit psychofysisch onderzoek, waarbij mensen moeten aangeven of auditieve en visuele stimuli synchroon lopen (geen spraak stimuli) dat gemiddeld genomen de sterkste synchroniciteit wordt gevonden bij een delay van de auditieve stimulus van ca. 50 ms (Stone et al., 2001). Verder blijkt uit elektrofysiologisch onderzoek dat audiovisuele integratie in belangrijke integratiegebieden in de hersenen (b.v. superior colliculus) het sterkst is bij een delay van de visuele stimulus van ca. 80 ms (Wallace and Stein, 1997). Dit kan worden verklaard door het gegeven dat visuele informatie langzamer wordt verwerkt dan auditieve informatie. Op het niveau van de superior colliculus komt visuele en auditieve informatie gelijktijdig aan wanneer visuele informatie 80 ms voor de auditieve informatie wordt aangeboden. Een andere verklaring voor de maximale integratie bij een vertraging van de auditieve input kan worden gezocht in de relatief lage geluidssnelheid. Bij het waarnemen van een geluidsbron die zich op enige afstand van de luisteraar bevindt zal de auditieve informatie dus later bij de waarnemer aankomen dan de visuele informatie. Uit recent onderzoek blijkt dat het punt waarop mensen de synchroniciteit van auditieve en visuele informatie als maximaal beoordelen afhankelijk is van de afstand tussen waarnemer en geluidsbron (Sugita and Suzuki, 2003). In dit project zal worden nagegaan of variatie van de (gesimuleerde) afstand tussen luisteraar en geluidsbron het McGurk effect kan be´nvloeden.

Auidiovisuele spraakherkenning bij visuele delay.

De audiovisuele integratie is voor simpele McGurk stimuli maximaal bij een delay van de visuele stimulus. Het lijkt een voor de hand liggende veronderstelling dat het positieve effect van visuele input op de verstaanbaarheid van spraak maximaal zal zijn bij eenzelfde delay. Wanneer dit zo is kan er, om spraakverstaan te optimaliseren, in films beter een audiovisueel delay worden aangebracht! Echter, het kan ook zo zijn dat dit effect wel voor simpele McGurk stimuli opgaat, maar niet voor complexe spraakstimuli. In een project zal worden gekeken of de toename van de verstaanbaarheid van spraakstimuli in ruis wordt vergroot door een delay aan te brengen tussen de auditieve en visuele stimuli.

Audiovisuele integratie bij niet-spraak stimuli.

Het McGurk-effect is een mooie stimulus om integratie te bestuderen omdat dat wat wordt waargenomen afhangt van het wel of niet ge´ntegreerd zijn van audiovisuele informatie. Ook voor stimuli die niets met spraak te maken hebben kan de waarneming van de omgeving veranderen afhankelijk van het wel of niet integreren van auditieve en visuele informatie. Een voorbeeld daarvan is de waarneming van voorwerpen die elkaar naderen. Op het moment dat deze voorwerpen elkaar in het visuele beeld raken kan de situatie op twee manieren worden ge´nterpreteerd: 1. de voorwerpen passeren elkaar op verschillende afstand (geen botsing). 2. de voorwerpen botsen en bewegen na de botsing in tegenovergestelde richting. Wanneer er op het moment van de 'botsing' een bots-geluid wordt aangeboden wordt situatie 2 vaker waargenomen (Bushara et al., 2003)).

In dit project zal in de eerste plaats worden geprobeerd om de resultaten van Bushara et al. te repliceren. Vervolgens zal worden nagegaan hoe groot het tijdswindow waarbinnen integratie optreedt is voor deze 'niet-spraak' stimuli.

Referentie lijst

Bushara,K.O., Hanakawa,T., Immisch,I., Toma,K., Kansaku,K., and Hallett,M. (2003). Neural correlates of cross-modal binding. Nature Neuroscience 6, 190-195.

McGurk,H. and MacDonald,J. (1976). Hearing lips and seeing voices. Nature 264, 746-748.

Stone,J.V., Hunkin,N.M., Porrill,J., Wood,R., Keeler,V., Beanland,M., Port,M., and Porter,N.R. (2001). When is now? Perception of simultaneity. Proc. R. Soc. Lond B Biol. Sci. 268, 31-38.

Sugita,Y. and Suzuki,Y. (2003). Audiovisual perception: Implicit estimation of sound-arrival time. Nature 421, 911.

Wallace,M.T. and Stein,B.E. (1997). Development of multisensory neurons and multisensory integration in cat superior colliculus. J. Neurosci. 17, 2429-2444.

Vereisten voor deze projecten:

- belangstelling voor multi sensorische informatie verwerking bij mensen.

- belangstelling voor fysische eigenschappen van geluid.

- belangstelling voor psychofysica.

- gewenste voorkennis: taal en spraaktechnologie, signaal analyse.

NB: Het psychofysisch onderzoek dient (afhankelijk van de uitkomst) ter voorbereiding van 'brain imaging' experimenten. Wanneer je ge´nteresseerd bent in fMRI (functionele magnetische resonantie imaging) kun je door het bijwonen van literatuur- en werkbesprekingen bij Biomedische Technologie hier wat over leren.

Contactpersoon:

Esther Wiersinga-Post (e-mail: j.e.c.post@phys.rug.nl, tel. 363-5557/4793)